यह कृत्रिम बुद्धिमत्ता पूर्वाग्रहों के अधीन है, एक ऐसी पुष्टि है जो अब किसी को आश्चर्यचकित नहीं करती है। ये एल्गोरिदम वास्तविक दुनिया से सीखते हैं, लेकिन उनकी गलतियों, पूर्वाग्रहों और असमानताओं को भी विरासत में लेते हैं। जो कुछ परेशान करना शुरू होता है, वह यह है कि इन विकृतियों के गलत प्रतिक्रियाओं या असफल फिल्टर से परे परिणाम हो सकते हैं। साइबर सुरक्षा के क्षेत्र में, एआई मॉडल में पूर्वाग्रह वे एक खतरनाक दरार बन सकते हैं जो हमलों की सुविधा, त्रुटियों का पता लगाने या वैध उपयोगकर्ताओं के खिलाफ भेदभाव की सुविधा प्रदान करता है।

एक डेटा बुलबुला जो रक्षा में छेद छोड़ता है

कई एआई मॉडल सीमित डेटा सेट पर विकसित किए जाते हैं, जो केवल कुछ सांस्कृतिक, भौगोलिक या तकनीकी पैटर्न को दर्शाते हैं। यह पक्षपाती दृष्टिकोण न केवल नैतिक या सामाजिक निर्णयों को प्रभावित करता है,, यह रक्षात्मक प्रणालियों की प्रभावशीलता से भी समझौता करता है। यदि एआई को अमेरिकी व्यापार नेटवर्क में विशिष्ट साइबर हमले के रिकॉर्ड के साथ प्रशिक्षित किया जाता है, तो यह लैटिन अमेरिका, अफ्रीका या एशिया में अलग -अलग संचालित होने वाले खतरों को पहचानने में असमर्थ हो सकता है।

साइबर सुरक्षा

साइबर सुरक्षा

यह एक दोहरी समस्या का कारण बनता है, एक तरफ, झूठी सकारात्मकता बढ़ जाती है, जब धमकियों का पता लगाया जाता है, जहां नहीं हैं, और दूसरी ओर, झूठे नकारात्मक, जब वास्तविक हमले किसी का ध्यान नहीं जाते हैं। वह प्रतिवेदन साइबरसेकरी खतरे का पता लगाने की सटीकता पर एआई एल्गोरिथ्म पूर्वाग्रह का प्रभाव उन्होंने पहले से ही 2023 में चेतावनी दी थी कि कैसे IoT उपकरणों पर एक बोटनेट्स डिटेक्शन सिस्टम को केवल एक ट्रैफ़िक विशेषता को संशोधित करके मजाक किया जा सकता है। हेरफेर किए गए डेटा द्वारा धोखा दिया गया एआई ने खतरा नहीं देखा।

हमलावरों द्वारा पूर्वाग्रह का उपयोग किया जाता है

परे धारणा विफलताओं से परे, साइबर क्रिमिनल द्वारा पूर्वाग्रहों का सक्रिय रूप से शोषण किया जा सकता है। इसने वैश्विक खपत संचालन के लिए जिम्मेदार हरवे लैंबर्ट को सतर्क किया है पांडा सुरक्षा: “हमलावर एक एआई के उत्तरों का अध्ययन कर सकते हैं और इसे झूठे अलर्ट के साथ ढहने या शोर के बीच उनके आंदोलनों को छिपाने के लिए हेरफेर कर सकते हैं“। यह एल्गोरिथम लॉजिक का एक विकृत उपयोग है जो सबसे उन्नत रक्षा प्रणालियों को खेल से बाहर छोड़ सकता है।

जैसे तकनीक जहर हमले, कि प्रशिक्षण डेटा, या जहर चोरी हमले, वह पता लगाने से बचने के लिए इनपुट को संशोधित करें, वे भीतर से एआई से समझौता करते हैं। इस प्रकार के हमले नए नहीं हैं, पहले से ही 2004 में, दुर्भावनापूर्ण ईमेल में सामान्य शब्दों को जोड़कर स्पैम बायेसियन फिल्टर का मजाक उड़ाया गया थाइस प्रकार यह प्राप्त करना कि वे वैध से गुजरेंगे। गायब होने से दूर यह रणनीति, वर्तमान स्वचालित प्रणालियों में काम करना जारी रखती है।

हाल के उदाहरण जोखिमों की पुष्टि करते हैं

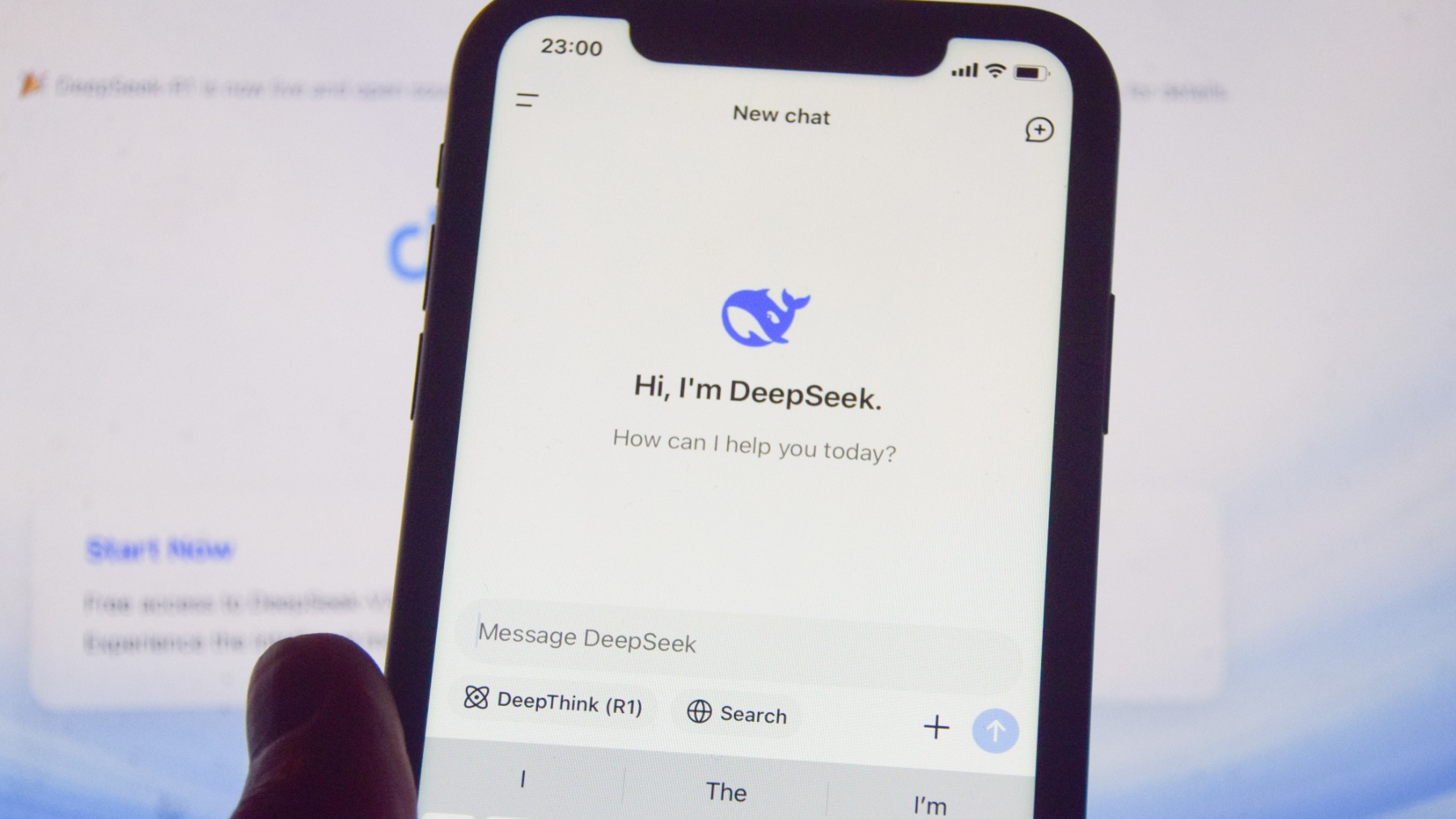

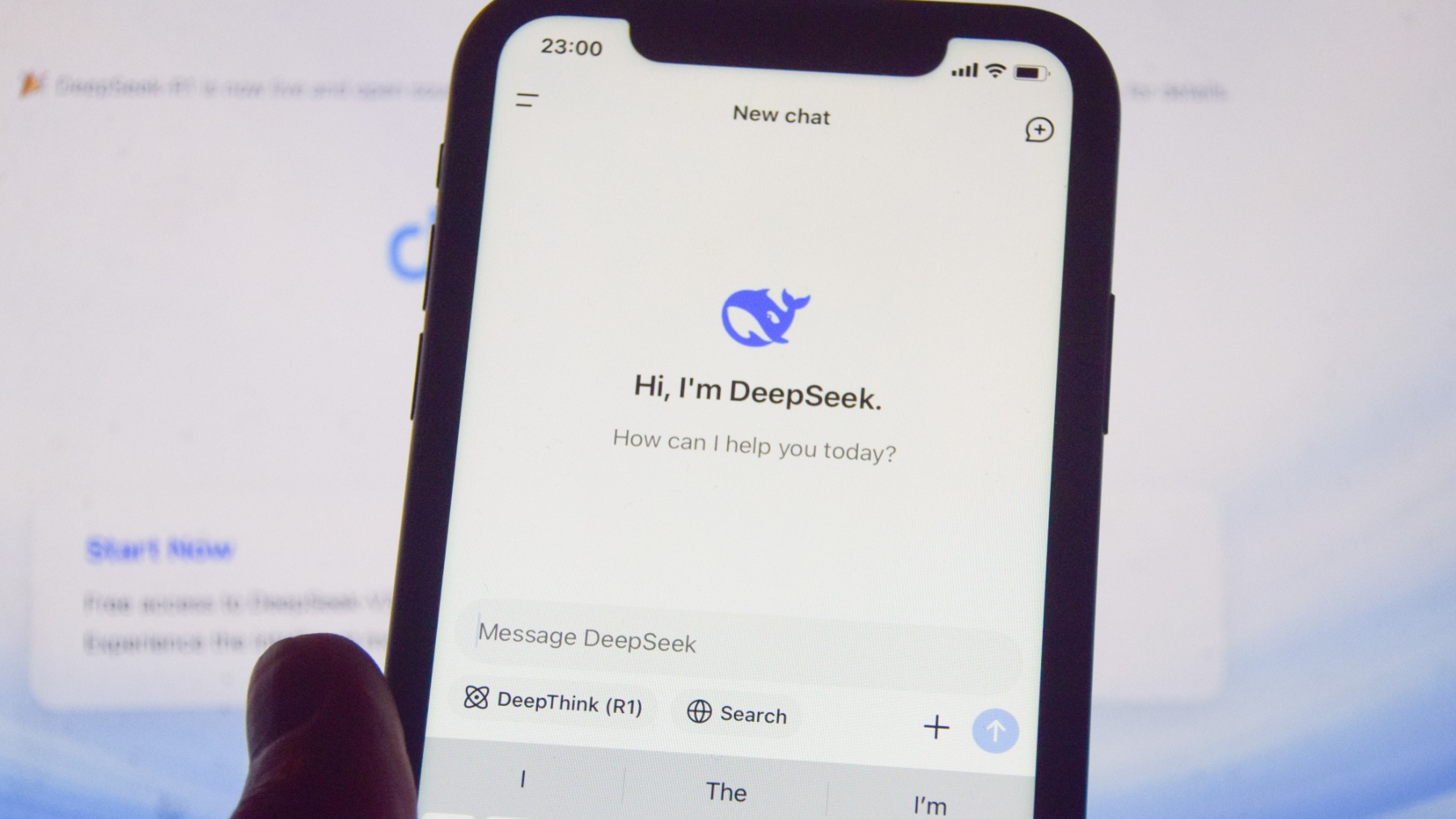

जनवरी 2025 में, चीन डेपसेक को खराब कॉन्फ़िगरेशन के कारण बड़े पैमाने पर डेटा निस्पंदन का सामना करना पड़ा। यद्यपि यह सीधे पूर्वाग्रह के कारण नहीं था, यह घटना यह उदाहरण देती है कि आर्टिफिशियल इंटेलिजेंस सिस्टम में ठोस नियंत्रण की अनुपस्थिति कैसे होती है यह महत्वपूर्ण अंतराल को जन्म दे सकता है। और, एल्गोरिथम डिजाइन से परे, इन प्रौद्योगिकियों के जीवन चक्र के प्रत्येक चरण की समीक्षा करना महत्वपूर्ण है: विकास से रखरखाव तक।

अपने मोबाइल फोन पर दीपसेक का उपयोग करने वाला व्यक्ति। (फोटो: ईपी)।

अपने मोबाइल फोन पर दीपसेक का उपयोग करने वाला व्यक्ति। (फोटो: ईपी)।

यूनिवर्सिटी ऑफ लेस इलिस ब्लेयर्स के नेतृत्व में यूरोपीय चार्ली जैसी परियोजनाएं, या ग्रांट थॉर्नटन यूके और मैनचेस्टर मेट्रोपॉलिटन यूनिवर्सिटी के साथ ब्रिटिश सरकार द्वारा प्रचारित अध्ययन, पहले से ही पहचानने और पहचानने और पहचानने और पहचानने के लिए काम कर रहे हैं और साइबर सुरक्षा परिदृश्यों में इन पूर्वाग्रहों को कम से कम करें। वे विश्लेषण करते हैं कि मॉडल के संचालन और विश्वसनीयता दोनों को प्रभावित करते हुए, शुरुआत से ही कैसे पक्षपात को सिस्टम में पेश किया जा सकता है।

समाधान जो एक निष्पक्ष एआई की ओर इशारा करते हैं

एल्गोरिदम में पूर्वाग्रह को कम करना डेटा की गुणवत्ता और विविधता में सुधार करना है। बड़ी कंपनियों से लेकर गैर सरकारी संगठनों या घरेलू नेटवर्क तक कई क्षेत्रों, उद्योगों, बुनियादी ढांचे के स्तर और उपयोगकर्ताओं के प्रकारों की जानकारी शामिल है, अधिक पूर्ण मॉडल बनाने में मदद करता है। यह भी उपयोगी है चालू कर देना डेटासेट सिंथेटिक जो दुर्लभ या उभरते खतरों का अनुकरण करते हैं, की तरह दीपफेक या नए रैंसमवेयर प्रकार।

मॉडलों की मान्यता एक कदम आगे जाना चाहिए। वह प्रतिकूल परीक्षणउदाहरण के लिए, सिस्टम के अंधे बिंदुओं का परीक्षण करने के लिए हेरफेर उदाहरणों का उपयोग करें। इसमें जोड़ा गया है निरंतर सीखने की आवश्यकता है, यह प्रशिक्षण को फिर से शुरू किए बिना ज्ञान को अपडेट करने की अनुमति देता है, और मानव ऑडिट जो महत्वपूर्ण निर्णयों की निगरानी करते हैं।

कुंजी एआई के लिए देयता छोड़ने के लिए नहीं है। हालांकि एल्गोरिदम जल्दी से जानकारी के बड़े संस्करणों का विश्लेषण कर सकते हैं, यह मानवीय हस्तक्षेप है जो यह सुनिश्चित करता है कि निर्णय भेदभाव या व्यवस्थित त्रुटि से चिह्नित नहीं हैं। केवल इस तरह से वास्तव में उपयोगी, सटीक और सुरक्षित कृत्रिम बुद्धिमत्ता का निर्माण किया जा सकता है।

Leave a Reply